Эффекты LLM на когнитивные функции

Отрицательные эффекты

Когнитивный оффлоадинг и падение критического мышления (cognitive offloading & critical thinking) — чем больше мы полагаемся на LLM, тем меньше тренируем собственный анализ.

Исследования показывают, что частое использование AI-инструментов связано со снижением критического мышления, а оффлоадинг выступает ключевым посредником

(Gerlich, 2025;

Lee et al., 2025).

Что делать: использовать LLM после собственного чернового ответа, а не вместо него; отдельно отрабатывать навыки аргументации без помощи моделей.

Где критично: обучение клиницистов и нейропсихологов, интерпретация данных нейровизуализации, принятие диагностических и терапевтических решений, разработка протоколов исследований в нейронауке.

Когнитивный долг и поверхностное усвоение (cognitive debt & shallow processing) — LLM экономит усилие сейчас, но ухудшает запоминание и глубину понимания.

Данные MIT и другие работы показывают: тексты, созданные с помощью LLM, хуже запоминаются, а глубина переработки материала снижается

(MIT study, 2025;

Chen et al., 2025).

Что делать: после работы с моделью обязательно пересказывать материал своими словами, делать короткие конспекты и проверочные вопросы к себе.

Где критично: освоение сложных концепций в когнитивных науках, нейрофизиологии, статистике и методологии исследований, подготовка к экзаменам и сертификация специалистов.

Иллюзия компетентности и метакогнитивная лень (metacognitive overconfidence & laziness) — с LLM всем начинает казаться, что они умнее, чем есть.

Эксперименты показывают: использование AI выравнивает или даже переворачивает эффект Даннинга–Крюгера — и менее, и более компетентные люди чаще переоценивают свои способности и хуже контролируют качество решений

(Aalto study, 2025;

Tian et al., 2025).

Что делать: вводить правило: «любой ответ модели требует проверки» — через альтернативные источники, расчёты, обсуждение в команде.

Где критично: клинические решения в психиатрии и неврологии, интерпретация когортных и нейровизуализационных исследований, разработка протоколов стимуляции и реабилитации.

Усталость от ИИ и перегрузка (AI fatigue & cognitive overload) — бесконечные диалоги с моделью могут выжигать внимание.

Работы по когнитивной нагрузке показывают: при длительном использовании GenAI растёт утомление, ухудшается концентрация и метакогнитивный контроль

(Chen et al., 2025;

Harvard Gazette, 2025).

Что делать: ограничивать время непрерывной работы с LLM, делать паузы без экранов, часть задач решать полностью офлайн.

Где критично: длительные нейро- и психофизиологические эксперименты, ночные дежурства врачей, аналитика больших наборов данных в нейронауках.

Риски для психического здоровья и зависимости от чатботов (mental health risks & dependency) — LLM могут стать «эмоциональным костылём», а не лечением.

Метанализы показывают пользу AI-чатботов для снижения депрессии и тревоги

(Zhong et al., 2024;

Li et al., 2025),

но регуляторы предупреждают о случаях вреда, дезинформации и эмоциональной зависимости, особенно у подростков

(NHS warning, 2025;

The Guardian, 2025).

Что делать: использовать чатботов только как дополнение к профессиональной помощи; избегать их в кризисных состояниях; внедрять фильтры для уязвимых групп.

Где критично: работа с пациентами с психозами, суицидальными мыслями, тяжёлой тревогой; программы цифровой психогигиены для подростков и студентов.

Положительные эффекты

Усиление обучения и успеваемости (learning gains) — LLM при грамотном использовании реально улучшают результаты обучения.

Метаналитики 2024–2025 годов показывают в среднем положительный эффект GenAI и LLM-интервенций на успеваемость и самостоятельное обучение

(Han et al., 2025;

Gu et al., 2025;

Biesta-framed LLM meta-analysis, 2025).

Как применять: использовать LLM как тьютора, который объясняет сложные концепции простым языком, задаёт проверочные вопросы, помогает строить планы обучения.

Где полезно: обучение ординаторов и аспирантов нейро- и когнитивным наукам, статистике, программированию, анализу нейроданных.

Поддержка креативности (creativity enhancement) — LLM помогают генерировать и комбинировать идеи, особенно у менее опытных.

Исследования в дизайне и образовании фиксируют рост творческих результатов и улучшение концентрации при работе с AIGC-инструментами

(Wang et al., 2025;

Hwang, 2025;

Doshi et al., 2024).

Как применять: использовать LLM на стадии генерации гипотез, вариантов дизайна экспериментов, формулировки новых исследовательских вопросов.

Где полезно: проектирование нейроинтерфейсов, протоколов стимуляции и реабилитации, дизайна VR/AR-сред для экспериментов, разработки когнитивных задач.

Поддержка психического здоровья (mental health support) — AI-чатботы могут снижать симптомы депрессии и тревоги при корректном применении.

Систематические обзоры и RCT демонстрируют умеренный, но устойчивый эффект AI-чатботов на снижение депрессии и тревоги у взрослых и молодёжи

(Zhong et al., 2024;

Li et al., 2023;

Tong et al., 2025;

Manole et al., 2024;

APSA summary, 2025).

Как применять: как дополнительный инструмент между сессиями терапии, для отработки навыков CBT, мониторинга настроения, напоминаний о здоровых привычках.

Где полезно: университетские программы поддержки, реабилитация пациентов с лёгкими и умеренными депрессивными и тревожными расстройствами, digital-health проекты в психиатрии и неврологии.

Ускорение профессионального мышления и исследований (workflow acceleration & decision support) — LLM снимают часть аналитического и текстового груза.

Работы по GenAI в образовании и знания-интенсивных профессиях показывают повышение эффективности анализа текстов, планирования и самостоятельного обучения

(GAI education meta-analysis, 2025;

Maastricht AI in Education, 2025).

Как применять: для обзоров литературы, генерации протоколов, подготовки заявок, draft-анализа данных с последующей ручной проверкой.

Где полезно: нейрохирургия и нейрореабилитация, проекты в области BCI, крупные когортные и мультимодальные исследования в нейронауках.

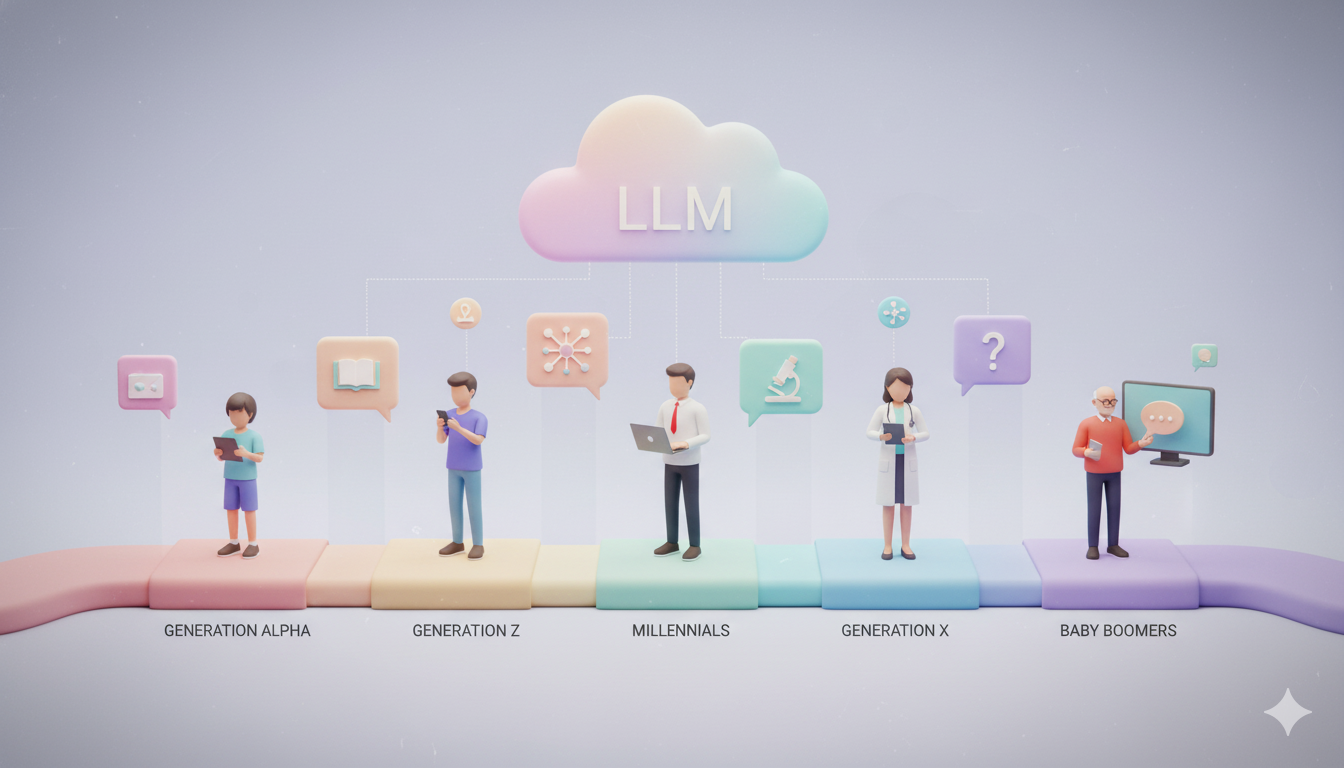

Поколения и прогноз когнитивных изменений

Поколение Alpha (дети и школьники) — вырастают сразу в паре «человек + LLM».

Ожидаемые изменения: сильная опора на внешние источники, быстрая навигация по информации, меньше практики глубокого чтения и запоминания.

Риски: метакогнитивная лень, эмоциональная привязанность к чатботам, подмена живого общения цифровым.

Рекомендации: встроить AI-грамотность в школьные курсы, обучать детей проверять ответы моделей, ограничивать терапевтическое использование чатботов.

Источники: мета-анализы по GenAI в образовании и обзоры по youth mental health чатботам

(Han et al., 2025;

Li et al., 2025).

Поколение Z (студенты и молодые специалисты) — интенсивно учатся и работают с LLM каждый день.

Ожидаемые изменения: рост продуктивности и креативности при гибридных стратегиях «co-creation» с LLM.

Риски: снижение критического мышления и всплеск академической нечестности при использовании LLM как «автоматического генератора ответов».

Рекомендации: чёткие правила использования AI в вузах, задания, где LLM используется для углубления понимания, а не для обхода обучения.

Источники: мета-аналитические работы о влиянии LLM и GenAI на студентов

(LLM meta-analysis, 2025;

Gu et al., 2025;

creativity in education, 2025).

Миллениалы (знание-воркеры, врачи, исследователи) — активно интегрируют LLM в профессиональные процессы.

Ожидаемые изменения: ускорение анализа, подготовки текстов, обзоров литературы и протоколов.

Риски: «профессиональная атрофия» рутинных навыков (написание, поиск ошибок, память на детали), переоценка собственных возможностей за счёт AI.

Рекомендации: регламентировать использование LLM как ассистента, а не источника окончательных решений; сохранять регулярную ручную практику ключевых когнитивных задач.

Источники: исследования по LLM-поддержке самостоятельного обучения и рискам когнитивной атрофии

(Polytechnique Insights, 2025;

Aalto study, 2025).

Поколение X (старшие специалисты и руководители) — выборочное и прагматичное использование LLM.

Ожидаемые изменения: точечное повышение эффективности при подготовке документов, презентаций, отчётов.

Риски: недоверие к AI там, где он реально полезен, и одновременно некритическое принятие удобных ответов без достаточной проверки.

Рекомендации: программы повышения AI-грамотности, совместная работа в парах «младший + старший» с обсуждением того, где модель помогает, а где нет.

Источники: обзоры по AI-внедрению в образовании и профессиональной среде

(Maastricht AI in Education, 2025;

Harvard Gazette, 2025).

Бэби-бумеры (старшее поколение) — используют LLM как удобный «поисковик с объяснениями» и иногда как собеседника.

Ожидаемые изменения: расширение доступа к информации и цифровым сервисам, потенциальная поддержка когнитивных функций и настроения.

Риски: дезинформация при низкой цифровой грамотности, зависимость от «доброго чатбота» вместо обращения к врачу.

Рекомендации: простые интерфейсы, базовые курсы цифровой и AI-грамотности, поддержка семей и медработников при использовании LLM для здоровья.

Источники: обзоры по AI-чатботам в ментальном здоровье и цифровым вмешательствам для взрослых

(Li et al., 2023;

APSA summary, 2025).